AIの進化が要求する「電力」という新たな課題

AI、特にSoraのような高性能な動画生成モデルの登場は、技術的なブレークスルーであると同時に、膨大な電力消費という新たな課題を浮き彫りにしています。OpenAIのサム・アルトマン氏自身も、将来のAIが必要とするエネルギーの莫大さを指摘し、エネルギー革命の必要性を説いています。このレポートは、AIの電力消費の現状、Soraが示す未来、そして私たちが直面する課題と解決策を対話的に探るものです。

1. 現在の状況:データセンターの電力消費

AIブーム以前から、データセンターは世界の電力の大きな消費者でした。国際エネルギー機関(IEA)によると、2022年時点でデータセンター、AI、暗号通貨を合わせた電力消費は世界全体の約2%を占めています。まずは、この全体像を把握しましょう。

2. 課題の核心:生成AIのエネルギーコスト

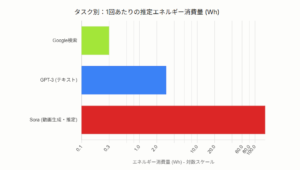

問題は、生成AIの「推論(Inference)」コストが従来タスクより桁違いに大きいことです。Google検索1回に比べ、GPT-3でのテキスト生成は約10倍の電力を消費すると推定されています。Soraのような動画生成は、その比ではありません。「5秒の動画生成に電子レンジ並み」という表現は、この「推論」1回あたりのエネルギーがいかに大きいかを示しています。

3. 2つのコスト:「学習」と「推論」

AIの電力コストには「学習(Training)」と「推論(Inference)」の2種類があります。「学習」はモデルを開発する際の一時的で莫大なコストですが、「推論」はユーザーがAIを使うたびに発生する継続的なコストです。SoraやChatGPTの普及は、この「推論」コストの総量が爆発的に増大することを意味します。

学習コスト

モデル開発時に1回だけ発生する、非常に高いエネルギーコスト。

- モデル: GPT-3 (175B)

- 推定消費電力: 1,287 MWh

- 例: 米国の約120世帯の年間電力消費に相当。

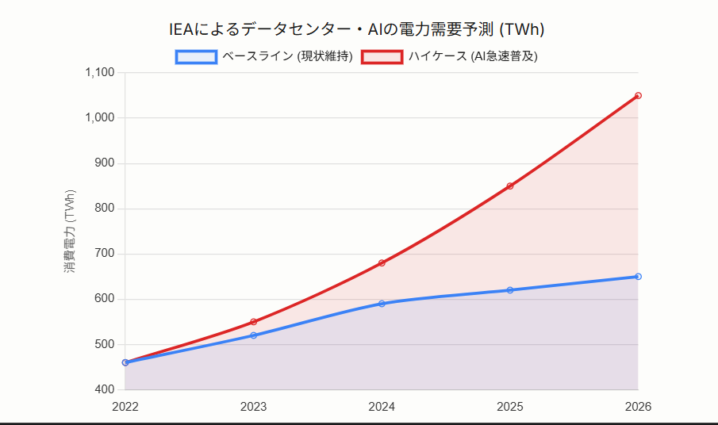

4. 将来の予測:2026年までの電力需要

IEAは、AIの普及ペースによって電力需要がどう変わるか、複数のシナリオを提示しています。以下のグラフは、データセンターとAIの電力需要が、現状維持のベースラインケースと、AIが急速に普及するハイケースでどのように分岐するかを示しています。Soraのようなモデルの普及は、この予測を「ハイケース」側、あるいはそれ以上に押し上げる可能性があります。

5. 解決への道:サム・アルトマン氏の視点

この指数関数的な需要増に対し、サム・アルトマン氏は「エネルギーのブレークスルーが必要だ」と述べています。彼は特に、安全で安価な「核融合」エネルギーに大きな期待を寄せています。従来の改善策だけでは追いつかないという認識です。私たちが取り組むべき解決策は、複数の階層にわたります。

1. 効率化(ハードとソフト)

より電力効率の高い新型GPUやAIチップの開発。また、モデルの軽量化やアルゴリズムの改善による、ソフトウェア側でのエネルギー削減。2. 再生可能エネルギー

データセンターの電力を太陽光や風力などの再生可能エネルギーで賄う取り組み。MicrosoftやGoogleは、100%再生可能エネルギーでの運用を目標に掲げています。3. 新たなエネルギー源

アルトマン氏が指摘する、核融合や次世代の原子力発電など、根本的に安価でクリーン、かつ大量のエネルギーを供給できる新しい技術への投資と開発。AIの電力需要に関する網羅的分析:

Soraの登場、サム・アルトマンの戦略、およびIEAによる2030年までのグローバル予測

エグゼクティブ・サマリー

本レポートは、OpenAIの動画生成AI「Sora」の登場と、それに伴うサム・アルトマン氏(OpenAI CEO)の発言に端を発する、AIの電力消費に関する包括的な分析を提供する。ユーザーから提起された「5秒の動画生成に電子レンジ並みの電力」という主張の検証から始まり、OpenAIのエネルギー戦略、そして権威ある国際機関による最新のマクロ予測までを詳細に検証する。本分析から得られた核心的な知見は以下の通りである。

- Soraの電力コスト:「電子レンジ並み」は桁違いの過小評価ユーザーの認識は、方向性としては正しいが、その規模を著しく過小評価している。MIT Technology Reviewによる2025年の最新分析によれば、「5秒間のAI動画生成」に必要なエネルギー(約3.4メガジュール)は、電子レンジを数秒稼働させるレベルではなく、「1時間以上」連続稼働させるエネルギー量に匹敵する 1。さらに、Hugging Faceの研究により、動画生成のエネルギーコストは動画の長さに対して「非線形(2次関数的)」に増大し、動画長が2倍になると消費電力は4倍になることが示唆されている 4。Soraの登場は、AIが本格的な「高エネルギー消費領域」に突入したことを示す転換点である。

- サム・アルトマンの3層エネルギー戦略アルトマン氏は、このエネルギー制約をAGI(汎用人工知能)開発における最大のボトルネックと認識し、多層的な戦略で対処している。

- 国家戦略レベル: OpenAIは米国政府に対し、中国との「電子ギャップ」 6 を埋めるため、「年間100GW(ギガワット)」(原子炉100基分に相当)という国家規模の電力増強を可能にする政策(規制緩和、投資)を提言している 6。

- 企業インフラレベル: ギガワット級の電力を前提とする次世代データセンター「Stargate」プロジェクト 8 を推進。その電力源として、SMR(小型モジュール炉)、太陽光、CCUS(二酸化炭素回収・貯留)を組み合わせた現実的なベースロード電源の確保を目指している 8。

- 長期的解決策(個人): アルトマン氏個人は、AIの究極の電源として核融合(Nuclear Fusion)に賭け、Helion Energy社に3億7500万ドルという巨額の私財を投じている 9。

- マクロ予測:2030年、AIは日本全体の電力消費量に匹敵するIEA(国際エネルギー機関)が2025年4月に発表した最新の権威あるレポート「Energy and AI」は、AIを「最も重要な牽引役」として、世界のデータセンターの電力需要が2030年までに*945TWh(テラワット時)*に達し、現在の水準から倍増すると予測している 11。この数値は、現在の日本全体の年間総電力消費量(約940TWh)に匹敵する。

序章:Soraと「電子レンジ」—動画生成AIのエネルギー消費インパクトの検証

AIの電力消費に関する議論は、OpenAIがSoraを発表したことで新たな局面を迎えた。ユーザーが指摘する「5秒の動画生成に電子レンジ並みの電力が必要」という言説は、この懸念を象徴している。本セクションでは、この具体的な主張のファクトチェック(事実検証)から始め、動画生成AIが持つ特異なエネルギー消費構造を定量的に明らかにする。1.1. 焦点となる主張の解剖:「5秒の動画生成=電子レンジ」という言説の検証

この「電子レンジ並み」という言説は、漠然とした噂や印象論ではない。その主要な出所は、2025年5月にMIT Technology Reviewが発表した「We did the math on AI’s energy footprint(我々はAIのエネルギーフットプリントを計算した)」と題された詳細な調査レポート、およびそれに関連する分析である 1。このレポートは、AIがタスク(テキスト、画像、動画)ごとにどれだけのエネルギーを消費するかを、ジュール(J)という物理単位で具体的に算出しようと試みたものである。1.2. 定量的検証:3.4メガジュールの衝撃と「1時間の誤解」

このMITによる調査の核心的なデータは、「最新のAIモデルが5秒間の動画を生成するために使用するエネルギーは『約3.4メガジュール(3.4 million joules)』である」という点にある 1。この「3.4メガジュール」という数値が、ユーザーの持つ「電子レンジ並み」という認識のずれを生む原因となっている。一般的なAIタスク、例えばChatGPTへの複雑な質問(テキスト生成)のエネルギーコストは約6,706ジュールであり、これは家庭用電子レンジ(800W〜1000W)を「約8秒」稼働させるエネルギーに相当する 2。このレベルであれば「電子レンジ並み」という表現は妥当かもしれない。

しかし、Soraのような動画生成AIが消費する3.4メガジュール(3,400,000ジュール)は、これとは比較にならない。MITのレポートは、このエネルギー量が「電子レンジを1時間以上(over an hour)」連続で稼働させることに相当すると結論付けている 1。

したがって、ユーザーの認識は、Soraの電力消費の深刻さを著しく過小評価している。問題は、AI動画生成が「電子レンジ並み」の電力を消費することではなく、「電子レンジを1時間つけっぱなしにする」ほどの膨大なエネルギーを、わずか5秒のコンテンツを1回生成する(推論する)ために消費する点にある。

1.3. AIタスク別 電力消費の比較

AIのタスクがリッチ化(マルチモーダル化)するにつれて、エネルギーコストがどのように指数関数的に増加するかを明確にするため、MITのレポート 2 および関連データ 1 に基づき、主要なAIタスクの推論(Inference)エネルギーコストを比較する。表1:AIタスク別 推論エネルギーコストの比較分析

| タスク種別 | 推定エネルギー消費量(ジュール) | 一般的な電子レンジ(800W)での稼働時間に換算 | データ出典 |

| テキスト生成 (単純なクエリ, 例: 「ありがとう」) | 114 J | 約 0.14秒 | [2, 16] |

| テキスト生成 (複雑なクエリ) | 6,706 J | 約 8.4秒 | 2 |

| 画像生成 (高品質, 1024×1024) | 約 4,857 J (動画の1/700) | 約 6.1秒 | [1, 2, 5] |

| 動画生成 (5秒) | 3,400,000 J (3.4 MJ) | 約 4,250秒 (約1時間11分) | 1 |

この比較表は、テキスト生成や画像生成のコストが「電子レンジで数秒」の範囲に収まるのに対し、動画生成のコストがそこから約500倍から700倍 1 という桁違いの飛躍をしていることを視覚的に示している。Soraの登場は、AIが本格的にこの「メガジュール級」のエネルギー消費領域に突入したことを示す象徴的な出来事である。

1.4. なぜ動画は桁違いに電力を消費するのか?

動画生成のエネルギーコストが桁違いに大きい理由は、単に多くの画像を連続で生成しているからだけではない 17。第一の技術的要因は、「時間的整合性(Temporal Consistency)」の維持に必要な膨大な計算コストである 18。Soraのような高度な動画モデルは、単に写実的な画像を生成するだけでなく、フレーム間(時間の経過)において、登場するオブジェクトの同一性、物理法則の(一見した)正しさ、背景の一貫性を保持し続ける必要がある 18。この「時間」という新しい次元が加わることで、計算の複雑さと必要とされる計算資源(GPU要件)は爆発的に増大する 18。

第二の、そしてより深刻な要因は、「非線形スケーリング(Non-linear Scaling)」の罠である。2025年9月に発表されたHugging Faceの研究者(Sasha Luccioni氏ら)による画期的な論文 4 は、この問題の核心を突いている。

この研究は、オープンソースのテキスト-to-動画モデルを用い、動画の長さ(Temporal length)や解像度(Spatial resolution)とエネルギー消費の関係を測定した。その結果、エネルギー需要は、動画の長さや解像度に対して「2次関数的(Quadratic)」に増加することが示された 21。

具体的には、動画の長さを2倍(例:3秒から6秒)にすると、エネルギー消費は単純な2倍ではなく、4倍($2^2$)になることが報告されている 4。

この非線形スケーリングという事実は、AIの電力問題を考える上で極めて重要である。ユーザーは「5秒のSora」の電力コストを懸念しているが、Sora 2のデモではすでに25秒の動画が生成されている 23。もしこの「2倍の長さ=4倍の電力」という法則がSoraにも適用されるならば、動画の長さを5秒から25秒へと5倍に延長することは、エネルギーコストの25倍($5^2$)の増加を意味する可能性がある。

Soraが示したAIの電力問題の真の危機は、「5秒の動画が電子レンジ1時間分」であること以上に、動画が実用的な長さ(数分)や品質(4K)に近づくほど、そのエネルギーコストが予測不可能なレベルで非線形に爆発する 5 という構造そのものにある。

第1部:需要の設計者—サム・アルトマンとOpenAIの多層的エネルギー戦略

Soraによって顕在化した「エネルギーの崖」に対し、その中心にいるサム・アルトマン氏とOpenAIは、この問題を単なる「コスト問題」としてではなく、「文明レベルのインフラ問題」および「地政学的問題」として捉え、多層的な戦略を同時並行で進めている。2.1. レベル1(認識と動機):エネルギー制約の直視とSoraの「真の目的」

サム・アルトマン氏は、AIの進歩が電力(Energy)と計算資源(Compute)によって根本的に制約されることを深く認識している。彼はAMDのAIカンファレンスにおいて、AIが将来的に「地球の総電力のかなりの部分(Significant Fraction of Earth’s Total Electricity)」を必要とするだろうと公言している 24。この莫大な計算コストは、アルトマン氏にとって常に現実的な経営課題である。彼が2025年4月に(冗談めかしながらも)「ChatGPTに『お願いします』や『ありがとう』といった礼儀正しい言葉を入力するだけで、OpenAIは数千万ドル(数十億円)の電力コストを失っている」と述べた 16 のは、その認識の表れである。

この文脈でSoraの役割を捉え直す必要がある。Sora 2は、そのデモの品質とは裏腹に、一部からは「スロップ(Slop)」(AIによって生成された無価値なコンテンツ)であるとの批判も受けた 25。なぜOpenAIは、このような高コストな製品を急いでリリースするのか。

アルトマン氏自身が、その動機について「AIが科学(science)を行うための資本(capital)が必要であり、その膨大な計算需要(compute need)を満たすために、途中で製品をリリースして『いくらかのお金を稼ぐ(make some money)』必要がある」と認めている 25。

Soraは、AIの圧倒的な能力を示すデモンストレーションであると同時に、その開発と運用に必要な天文学的なGPUインフラ費用 18 を早急に回収するための収益源(マネタイゼーション・ツール) 26 として機能するという、二重の役割を担っている。Soraが引き起こす「需要の爆発」は、そのまま「収益の爆発」に転換されなければ、OpenAIのAGI開発戦略そのものが破綻しかねない。

2.2. レベル2(国家戦略):OpenAIの政策提言と「電子ギャップ」

アルトマン氏は、AGIの実現に不可欠な莫大なエネルギーインフラのコストとリスクを、OpenAI一社で負うことは不可能であると判断している。そこで彼は、この問題を「国家安全保障問題」にリフレーミング(再定義)し、米国政府の政策に組み込もうとしている。OpenAIは、電力を単なる公共サービスではなく、AI時代における「戦略的資産(strategic asset)」 6 と明確に位置づけ、ホワイトハウス科学技術政策局(OSTP) 6 やエネルギー省(DOE) 27 に対し、強力な政策提言を行っている。

その提言の核心は、中国との「電子ギャップ(electron gap)」という脅威である 6。OpenAIの最高グローバル担当責任者(Christopher Lehane氏)は、2024年(※訳注:2025年10月の書簡で2024年のデータを引用 7)に中国が429GWの新規電力容量を追加したのに対し、米国はわずか51GWであったと指摘 7。この電力インフラの差が、米国のAI覇権を根本から脅かすと警告している。

このギャップを埋めるため、OpenAIは米国政府に対し、「年間100ギガワット(GW)の追加電力容量」の建設を可能にするための緊急の行動(規制緩和、投資)を要求している 6。100GWという規模は、年間100基の大型原子力発電所を新設するに等しい、驚異的な要求である。

これは、OpenAIが自社のインフラコストを、米国の国家予算と安全保障政策によって「社会化(de-risk)」しようとする極めて高度な戦略である。

2.3. レベル3(企業インフラ):「Stargate」プロジェクトとベースロード電源の確保

OpenAIが国家レベルで要求する電力インフラの受け皿として計画されているのが、次世代AIデータセンター「Stargate」プロジェクトである 8。このプロジェクトは、最終的に*15ギガワット(GW)*という、小国全体の電力使用量に匹敵する電力を必要とすると報じられている 8。

注目すべきは、そのエネルギーミックス戦略である。OpenAIは「100%再生可能エネルギー」といった理想論に依存していない。Stargateの計画は、AIデータセンターの「24時間365日の安定稼働」に不可欠な「ベースロード電力」の確保を最優先している 8。

そのために計画されている具体的な電源構成は、以下の3つの組み合わせである 8:

- SMR(小型モジュール炉): 需要地(データセンター)の近くに設置可能な、安定したカーボンフリー電力源として導入が計画されている。

- 太陽光発電 + バッテリー貯蔵: 変動性のある再生可能エネルギーをバッテリーで補完する。

- 天然ガス + CCUS(二酸化炭素回収・貯留): 現実的なベースロード電源として天然ガスを引き続き利用しつつ、排出されるCO2をCCUS技術で回収し、環境負荷に対応する。

2.4. レベル4(究極の解決策):サム・アルトマンと「核融合」への個人的な賭け

アルトマン氏は、AI(特にAGI)の将来は「エネルギーのブレイクスルー(energy breakthrough)」 9 にかかっていると公言している。彼がSMRやCCUS(レベル3)といった「既存技術の延長」と並行して、個人的に巨額の投資を行っているのが、究極の解決策としての「核融合(Nuclear Fusion)」である。アルトマン氏は2015年から核融合スタートアップ「Helion Energy」の会長を務め 10、2021年には個人として3億7500万ドルという巨額の資金を同社に投じている 9。これは彼のポートフォリオの中で最大級の個人的な賭けである。

この投資は単なる趣味ではない。AIと核融合は共生関係にある。AIデータセンターは核融合にとっての「最初の安定した大口顧客」となり、核融合はAIにとっての「究極のクリーンなベースロード電源」となる 9。GoogleやNvidiaなども、Helionや他の核融合スタートアップ(CFS, TAE)に投資しており 9、シリコンバレーのAI開発者たちは、自らが生み出す莫大な電力需要の解決策を、自ら支援している。

アルトマン氏の戦略は、時間軸の異なるポートフォリオである。

- 短期(〜2030年): Soraの収益化(レベル1)と、国家政策による電力網の強化(レベル2)で時間を稼ぐ。

- 中期(〜2035年): Stargateプロジェクト(レベル3)により、SMR、CCUS、再生可能エネルギーを組み合わせたギガワット級の「AGI用インフラ」を構築する。

- 長期(2035年〜): AGIが真に社会実装され、エネルギー需要がテラワット級に達する未来に、Helion(レベル4)の核融合が安価な(1セント/kWhが目標 10)無尽蔵の電力を供給する。

第2部:マクロ予測—AIは最終的にどれだけの電力を必要とするか?

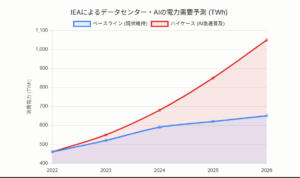

Sora(ミクロ)とアルトマン氏の戦略(キープレイヤー)の分析を踏まえ、本セクションでは「結局AIに必要な電力量はどうなるか」というユーザーの核心的な問いに対し、最も権威あるグローバルなマクロ予測を用いて定量的に回答する。3.1. 決定版データ:IEA(国際エネルギー機関)「Energy and AI」レポート(2025年4月)の徹底分析

AIの電力需要に関する議論において、現在最も信頼性が高く、包括的なデータは、IEA(国際エネルギー機関)が2025年4月10日に発表した特別レポート「Energy and AI」である 11。このレポートは、世界のデータセンターの電力消費量が、2030年までに約945TWh(テラワット時)に達し、現在の水準(2024年)から倍増すると予測している 11。

この945TWhという数値の持つ意味は衝撃的である。これは、「現在(2025年時点)の日本全体の年間総電力消費量(約940TWh)をわずかに上回る」規模である 11。

そしてIEAは、この爆発的な需要増加の「最も重要な牽引役(the most significant driver)」はAIであると断定している 11。特に、AIに最適化されたデータセンターからの電力需要は、2030年までに4倍以上に増加すると予測されている 11。

3.2. 需要の構造的変化:AIが産業構造を塗り替える

IEAのレポートが示すのは、単なる電力消費量の増加ではない。AIが経済のエネルギー消費の構造を根本的に塗り替える歴史的な転換である。特に米国における影響は甚大である。IEAによれば、米国において、2030年までの電力需要増加の**ほぼ半分(almost half)**はデータセンター(AI)が占める 11。

さらに衝撃的な予測として、2030年までに、米国経済は「アルミニウム、鉄鋼、セメント、化学製品を合わせたすべてのエネルギー集約型製造業」よりも多くの電力を、データ処理(AI)のために消費するようになる、とされている 11。

これは、産業革命以来の「物理的なモノづくり(製造業)」から、「知的なモノづくり(AI)」へと、経済のエネルギー消費の主役が歴史的に交代することを意味する。AIは、電力網にとって単なる「新たな産業負荷」であるだけでなく、近い将来、「最大の産業負荷」になろうとしている 32。この現実が、電力インフラの逼迫 33 や、電力会社の計画見直しを余儀なくさせている。

3.3. 予測の不確実性:945TWhは「絶対」ではない

IEAの945TWhという予測は強力だが、これが確定した未来ではない。Goldman Sachsも2030年までにデータセンターの電力需要が160%〜165%増加する 34 と予測しており、IEAの「倍増」という見立てと近いレンジにある。しかし、IEAのレポート 36 を詳細に分析すると、より重要な事実が浮かび上がる。945TWhという数値は、IEAが設定した複数のシナリオ(「リフトオフケース」、「高効率ケース」など)の中の「ベースケース(Base Case)」の予測値である 36。

IEA自身、2030年のデータセンター電力需要に関するサードパーティの様々な予測を比較し、「最高予測と最低予測の間には7倍もの違いがある」と指摘している 36。

なぜ予測にこれほどの幅があるのか。IEAはレポートの中で「AIサービス需要の将来展望に関する包括的なデータが乏しい」こと 36、そしてAIの世界での現実の動向とエネルギー需要の見通しとの間の関連性を確立することが困難であること 36 を認めている。

その象徴的な例が、2025年1月に中国のスタートアップが発表した、高性能かつ低コストな新モデル「DeepSeek-R1」である 37。この発表は、AIの効率化が劇的に進む可能性を示唆し、市場に衝撃を与え、AI関連のテクノロジー株やエネルギー株が(一時的に)下落する事態を引き起こした 37。

この事実は、「AIに必要な電力量」の未来が、固定された数値ではないことを示している。それは、Soraのような需要を爆発させるイノベーション(リフトオフ・シナリオ)と、DeepSeek-R1のような効率を劇的に改善するイノベーション(高効率シナリオ)との間の、激しい「綱引き」の結果として決まる。

IEAの945TWhという予測は、その綱引きの「現在の見通し(ベースライン)」に過ぎないのである。

第3部:効率化による反撃—技術は自らの問題を解決できるか?

第2部で示した「需要の爆発」というマクロ予測に対し、「Green AI」(49)と呼ばれる対抗トレンドが存在する。それは、AIの電力効率化を目指す技術的なブレイクスルーであり、AIが自らのエネルギー問題を解決できる可能性を探る動きである。4.1. ソフトウェアとアルゴリズムによる最適化:「90%削減」の可能性

AIのエネルギー消費は、モデルの設計と使用方法に大きく依存する。2025年7月に発表されたUNESCOのレポート 12 は、AIのエネルギー需要を劇的に削減する実用的な方法を提示した。UCL(ユニバーシティ・カレッジ・ロンドン)の研究者らが行った実験(MetaのLlama 3.1 8Bモデルを使用)では、以下の手法を組み合わせることで、大規模な汎用AIモデルと比較して**最大90%**のエネルギー削減を達成できることが示された 12。

- 量子化(Quantization): モデル内部の計算で使用する数値の精度(小数点以下の桁数)を下げる 12。

- プロンプトの短縮: ユーザーの指示やAIの応答を短くする 12。

- タスク特化モデルの使用: GPT-4のような巨大汎用モデルではなく、特定のタスクに特化した小型モデルを使用する 12。

これらの事実は、「より大きく、より高性能に」という現在のトレンド 41 とは別に、「より小さく、より効率的に」というアプローチも並行して進んでおり、そこには90%という劇的な改善の余地が残されていることを示している。

4.2. ハードウェアの軍拡競争:Nvidia GPUの先にあるもの

現在のAIブームはNvidiaのGPU(H100など)によって支えられているが 42、GPUは本来グラフィックス用であり、AIの*推論(Inference)*タスク(ユーザーが実際にAIを使うプロセス)において必ずしも最も電力効率が高いわけではない。Soraの登場で「推論の電力コスト」が巨大な問題となった今、ハードウェアの競争軸は「電力効率(Performance per Watt)」へと急速にシフトしている。

- 新興勢力 (1) GroqのLPU: スタートアップ企業Groqは、GPU(Graphical Processing Unit)ではなく、LPU(Language Processing Unit)と呼ばれる推論タスクに特化した新アーキテクチャを開発した 13。GPUが苦手とする低遅延・高効率の処理を実現し 13、2025年9月には7.5億ドルの資金調達に成功し、NvidiaのCUDAエコシステム 42 に挑戦している。

- 新興勢力 (2) 新素材(GaN): 2025年11月、オンセミ(onsemi)は、従来のシリコンに代わり「縦型GaN(窒化ガリウム)」を用いたパワー半導体を発表した 44。これはAIデータセンターやEV向けに設計され、エネルギー損失を約50%低減し、電力密度と効率の新たなベンチマークを確立すると期待されている 44。

4.3. 「インセンティブの不整合」と経済的な転換点

これほどの効率化技術が存在するにもかかわらず、なぜAIの電力消費は増大し続けているのか。MITリンカーン・ラボの研究者は、この状況を「インセンティブの不整合(incentive-misalignment problem)」と指摘している 41。これまでのAI開発のレースは、「より大きく、より良いモデル(bigger and better models)」を作ることが最優先であり、エネルギー効率のような「二次的な考慮事項(secondary consideration)」は脇に置かれてきた 41。

しかし、SoraやGPT-4oのようなモデルの推論コストが、AIサービスの運用コストの大部分を占めるようになった今、このインセンティブ構造は根本から覆りつつある。

Soraが引き起こした「エネルギー危機」(序章)そのものが、AI企業にとって、これまで「二次的」であったエネルギー効率を、「一次的」な経営課題(=収益性)へと転換させた。AI企業は今や、コスト削減のために、より電力効率の高いアルゴリズム(90%削減の可能性 12)とハードウェア(Groq LPUなど 13)を、経済的な理由で採用せざるを得なくなっている。

IEAの945TWhという予測(第2部)は、「能力」追求のトレンドが続いた場合の未来である。しかし、Sora自身が引き起こした「危機」が、市場のインセンティブを「効率」へと反転させ、その「90%削減」のポテンシャルを解放する引き金になる可能性も秘めている。

4.4. 逆転する役割:AIが電力網を最適化し、エネルギーを「節約」する未来

最後に、AIは一方的に電力を消費する「問題」であると同時に、エネルギーシステム全体の効率化に貢献する「解決策」でもあるという側面を見逃してはならない 45。- グリッド管理: AIは電力網の負荷を予測・平準化し(負荷シフト 46)、障害を予測・特定し(30)、送電網の容量を(新しい送電線を建設せずに)増加させることができる 30。

- 再生可能エネルギーの最適化: AIは天候を予測し、太陽光や風力発電の変動性を管理し、その統合を支援する 47。

- データセンターの自己最適化: Googleは、AIを用いて自社のデータセンターの冷却システムを最適化し、冷却に使用するエネルギーを40%削減したと報告している 47。

結論:制約の中の爆発的成長—AI電力需要の未来シナリオ

本レポートは、Soraの登場とサム・アルトマン氏の発言を基点に、AIの電力需要の未来を検証した。ユーザーの核心的な問い「結局AIに必要電力量はどうなるか」に対する最終的な回答は、IEAが示す「945TWh」という固定された未来像ではない。

それは、(1) Soraに代表されるマルチモーダル化による「需要の非線形な爆発」 4、(2) アルトマン氏が推進する**「国家規模のインフラ構築」** 6、そして (3) Green AIに代表される**「急進的な効率化」** 12 という、3つの巨大な力が激しく衝突する「戦場」そのものである。

Soraの役割は、AIの電力消費を「懸念」から「危機」へと格上げし、第3部の「効率化」と第1部の「インフラ構築」という2つの巨大な対抗策を起動させた触媒であると言える。

サム・アルトマン氏の3層戦略(Sora収益化、国家政策提言、核融合投資)は、この3つの力のすべてに同時に賭ける、極めて合理的なポートフォリオである。彼は、「効率化」が「需要」に追いつかなかった場合のインフラ(Stargate)を構築し、そのインフラすら限界に達した未来のために核融合(Helion)に投資している。

AIの電力需要は、もはや単なる技術的な制約ではない。それは「経済的」かつ「地政学的」な制約となった。サム・アルトマン氏が「電力は戦略的資産である」 6 と述べたとき、彼は単に「中国に勝つために電力が必要だ」と言ったのではない。彼は、「AIの未来を定義する者は、その電力を定義する者である」と宣言したのである。

Soraの登場は、その宣言が、もはやSFではなく、2025年現在の産業界とエネルギー政策における最大の課題であることを証明した。

コメントを残す